一、安装 NFS 服务器

# CentOS7.9 服务端节点安装:

yum -y install nfs-utils

# Ubuntu22.04 服务端节点安装:

# apt-get -y install nfs-kernel-server

mkdir /nfs-{1..6}

# 编辑/etc/exports,配置nfs服务

vim /etc/exports

/nfs-1 *(rw,no_root_squash,no_all_squash,sync)

/nfs-2 *(rw,no_root_squash,no_all_squash,sync)

/nfs-3 *(rw,no_root_squash,no_all_squash,sync)

/nfs-4 *(rw,no_root_squash,no_all_squash,sync)

/nfs-5 *(rw,no_root_squash,no_all_squash,sync)

/nfs-6 *(rw,no_root_squash,no_all_squash,sync)

# rw 表示客户端对共享的文件系统有读写权限。

# no_root_squash 表示在客户端使用 root 权限时,其权限不会被映射到匿名用户,root 拥有对共享目录的完全访问权限。

# no_all_squash 表示在客户端连接时,所有用户在 NFS 共享目录中的权限都将被保留。

# sync 表示 NFS 服务器将在写入完成之前等待数据被存储到磁盘上。

systemctl enable nfs-server

systemctl restart nfs-server

# Ubuntu重启服务

systemctl restart rpcbind.service

systemctl restart nfs-kernel-server.service

systemctl restart nfs-utils.service

systemctl restart nfs-server.service

# 增加NFS-SERVER开机自启动

systemctl enable nfs-server.service

# CentOS7.9 客户端节点:

# 客户端模拟挂载[所有k8s的节点都需要安装客户端]

# centos

yum install nfs-utils

# 或者(ubuntu)

# apt-get install nfs-common

systemctl enable nfs-server

systemctl restart nfs-server

# 查看nfs节点

showmount -e 192.168.8.201

Export list for 192.168.8.201:

/nfs-6 *

/nfs-5 *

/nfs-4 *

/nfs-3 *

/nfs-2 *

/nfs-1 *

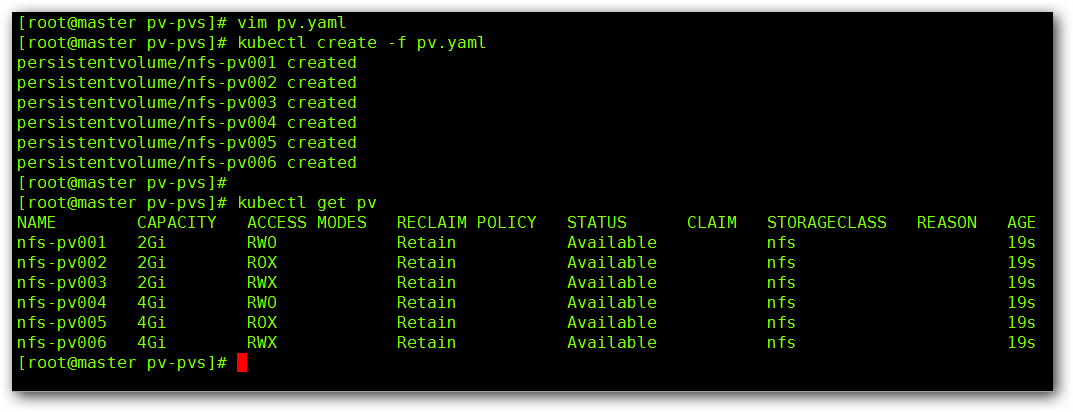

二、部署 PV

vim pv.yaml

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv001

spec:

capacity:

storage: 2Gi

accessModes:

- ReadWriteOnce

persistentVolumeReclaimPolicy: Retain

storageClassName: nfs

nfs:

path: /nfs-1

server: 192.168.8.201

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv002

spec:

capacity:

storage: 2Gi

accessModes:

- ReadOnlyMany

persistentVolumeReclaimPolicy: Retain

storageClassName: nfs

nfs:

path: /nfs-2

server: 192.168.8.201

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv003

spec:

capacity:

storage: 2Gi

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

storageClassName: nfs

nfs:

path: /nfs-3

server: 192.168.8.201

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv004

spec:

capacity:

storage: 4Gi

accessModes:

- ReadWriteOnce

persistentVolumeReclaimPolicy: Retain

storageClassName: nfs

nfs:

path: /nfs-4

server: 192.168.8.201

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv005

spec:

capacity:

storage: 4Gi

accessModes:

- ReadOnlyMany

persistentVolumeReclaimPolicy: Retain

storageClassName: nfs

nfs:

path: /nfs-5

server: 192.168.8.201

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv006

spec:

capacity:

storage: 4Gi

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

storageClassName: nfs

nfs:

path: /nfs-6

server: 192.168.8.201

三、创建服务并使用 PVC

vim statefuset.yaml

apiVersion: v1

kind: Service

metadata:

name: nginx

labels:

app: nginx

spec:

ports:

- port: 80

name: web

clusterIP: None

selector:

app: nginx

---

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: web

spec:

selector:

matchLabels:

app: nginx

serviceName: "nginx"

replicas: 3

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: docker.io/nginx

imagePullPolicy: IfNotPresent

ports:

- containerPort: 80

name: web

volumeMounts:

- name: www

mountPath: /usr/share/nginx/html

volumeClaimTemplates:

- metadata:

name: www

spec:

accessModes: [ "ReadWriteOnce" ]

storageClassName: "nfs"

resources:

requests:

storage: 1Gi

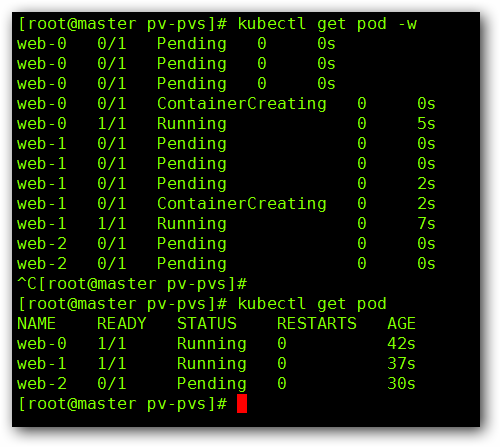

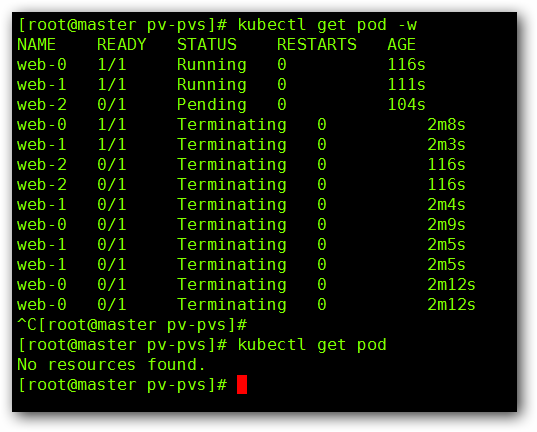

创建后我们来看一下效果,首先看一下 Pod 的创建过程:

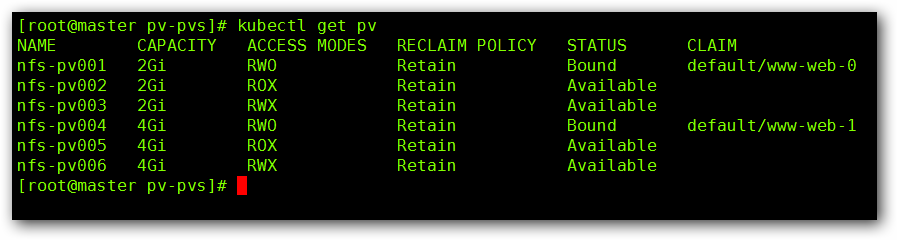

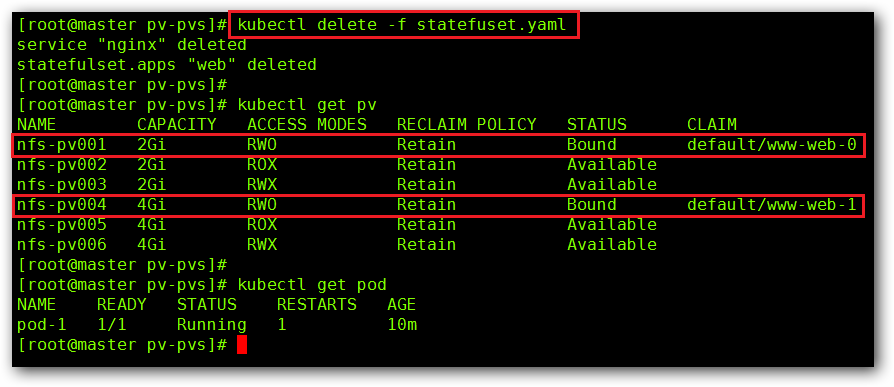

然后我们来看一下 PV 的状态:

通过上述实验截图,我们发现,我们定义了三个副本,但是只有两个副本处于 “running” 的状态,还有一个处于 “pending” 的状态,这是因为,我们定的 PV 的访问模式为 “ReadWriteOnce” , 以单个节点以读/写模式挂载,我们在创建PV 的时候只创建两个模式为 “ReadWriteOnce” 的 PV ,所以第三个 Pod 没有可用的 PV 进行挂载,所以创建不成功。

还有,我们要注意一下 StatefulSet 控制器,在创建的时候它是一个一个按照顺序的进行创建,在删除的时候,也是有序进行的删除。

四、PV 资源回收

我们将由 StatefulSet 控制器创建的 Pod 进行删除操作,然后我们在查看一下我们的 PV 的状态:

这里,我们可以看到,由 StatefulSet 控制器创建的 Pod 已经全部删除了,但是我们的 PV 资源还没有释放,这是因为我们回收策略的原因所导致的,那么我们来手动回收一下:

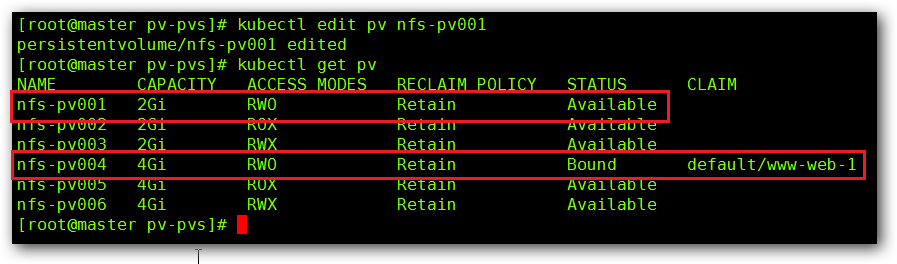

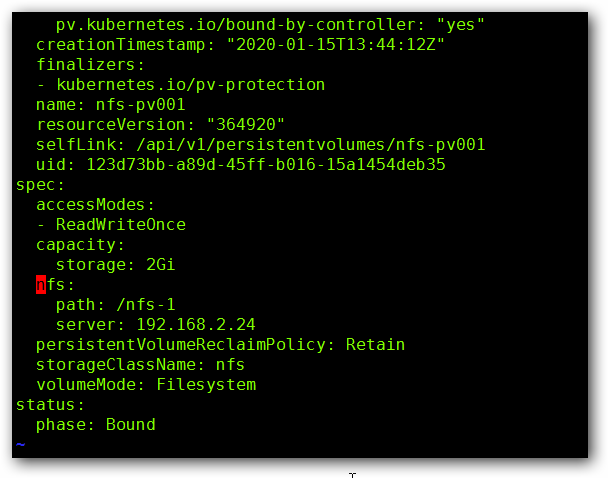

通过命令 kubectl edit pv nfs-pv001 来将 “claimRef” 字段进行删除,然后查看下 PV 状态。

删除 “claimRef” 前:

删除 “claimRef” 后:

然后查看下 PV 的状态: